Virtuose de l'informatique théorique, Gregory Chaitin a introduit deux notions révolutionnaires : le nombre Oméga et une première définition fonctionnelle du hasard.

Dans la première partie de cette chronique sur l'ordinateur quantique, on a parlé de l’annonce faite par Google, qui a embrasé l'espace médiatique international. Un nouvel appareil atteignait apparemment la suprématie quantique, c'est-à-dire une capacité de calcul qu'aucun ordinateur classique ne peut espérer égaler. J'en ai alors profité pour rappeler quelques règles du monde quantique, ainsi que les difficultés techniques exceptionnelles posées par la réalisation de ces hyperordinateurs. Dans cette deuxième partie, nous allons aborder les questions théoriques posées par l'architecture inédite de ces créatures exotiques.

La machine de Turing

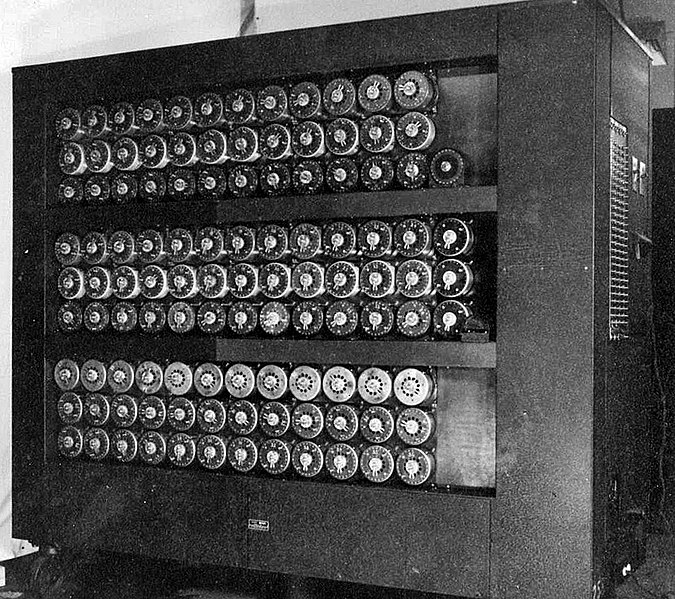

L'ordinateur classique répond aux normes d'une machine dite de Turing. Le nom et une partie du travail de ce mathématicien et logicien anglais ont été popularisés par l'excellent film américain Imitation Game (2014), mettant en vedette le grand Benedict Cumberbatch. On y traite de son travail d'analyste au service de la Grande-Bretagne, alors que lui et son équipe réussissent à percer le code d'Enigma, la machine de cryptage utilisée par les Allemands lors de la Deuxième Guerre mondiale. Cette réussite a certes contribué à la victoire des Alliés, mais Turing est aussi célèbre pour une autre raison : la machine virtuelle qui porte son nom. Une machine de Turing est un modèle théorique des appareils mécaniques de calcul; autrement dit, une machine universelle idéale. Il en a posé les bases dès les années 1930. On peut dire que l'appareil logique qu'il a plus tard conçu pour casser le code d'Enigma, comme d'ailleurs les ordinateurs actuels, constituent des incarnations de cet automate virtuel1. Pour en expliquer certains linéaments, nous allons effectuer une brève incursion dans le monde fascinant de l'informatique théorique.

C'est dans un célèbre article de 1936, « On computable numbers, with an application to the entscheidungsproblem », que Turing propose son modèle abstrait2. Son principe est simple : il s'agit de formaliser une procédure purement mécanique, un algorithme, qui peut être effectué par un automate3. Un programme informatique constitue un bon exemple d'algorithme, mais le concept lui-même est très ancien, puisqu'il remonte au géomètre Euclide et à Ératosthène, le mathématicien et géographe de la période hellénistique qui estima la circonférence de la Terre. Turing voulait en donner une définition à la fois originale et plus précise. Il imagine donc un ruban infini divisé en cases, et un automate virtuel emplissant ces cases grâce à une somme finie de symboles. Chaque case occupée constitue une étape, qui doit être exécutée selon une procédure élémentaire bien définie, laquelle conditionne les divers états de la machine. Lorsqu'une étape est terminée, on passe à la case adjacente de droite, le contenu de la case précédente déterminant celui de la suivante. Le processus doit se poursuivre jusqu'à ce que la décision d'arrêter soit prise.

Une telle machine effectue tous les calculs en réduisant chacun d'eux à une suite finie d'opérations élémentaires. Ce qui signifie que si un problème x est calculable (computable, dit Turing), alors il existe un automate programmable capable de le résoudre. C'est pourquoi Turing peut conclure en écrivant qu'une « suite calculable γ est déterminée par une description d'une machine qui calcule γ […] et, en fait, n'importe quelle suite calculable est susceptible d'être décrite en termes d'une table. » (« Table » réfère ici à l'algorithme qui anime sa machine virtuelle.)

L'architecture de von Neumann

Pour incarner le modèle formel de Turing, il fallut imaginer une architecture physique capable d'exécuter les divers algorithmes de sa machine universelle. À quelques améliorations près, l'ordinateur actuel repose encore sur la conception du mathématicien hongrois John von Neumann (1903-1957), réalisée à partir du modèle de Turing. C'est von Neumann qui en proposa, dès 1945, les composantes essentielles4 :

- une unité d'entrée pour donner les instructions à l'appareil5;

- une unité de traitement ou unité centrale, le processeur, constituée d'une unité de contrôle pour gérer les opérations et d'une unité arithmétique et logique;

- une mémoire interne pour emmagasiner les données6;

- et une unité de sortie pour produire le résultat7.

Pour mettre à profit une telle architecture, il suffit que l'on fournisse les données à l'appareil et que les instructions soient codées sous forme de programme à l'entrée, puis décodées sous forme de résultats à la sortie. Dans l'intervalle, l'unité de contrôle gère le déroulement des instructions et l'unité arithmétique et logique veille à leur exécution.

C'est ainsi que l'ordinateur devint la machine idéale pour gérer l'information sous diverses formes. Par la suite, les énormes tubes à vide utilisés dans les premiers appareils cédèrent la place aux transistors, puis aux microprocesseurs actuels, mais ce processus de miniaturisation ne modifia guère la configuration de base de von Neumann, même si, avec les générations successives, la vitesse et la puissance des ordinateurs s'accrurent de manière vertigineuse8.

La thèse de Church-Turing

Nous avons parlé d'algorithme, de codage et de décodage. Ici, il faut toucher un mot de ce qu'on appelle la théorie de la calculabilité, justement un des piliers de l'informatique théorique. Rappelons que Turing avait fait son doctorat avec le mathématicien et logicien américain Alonzo Church (1903-1995), l'un des ancêtres de l'informatique théorique et le créateur du lambda-calcul (λ-calcul), l'un des tout premiers langages théoriques de programmation. Ici, il faut toucher un mot de ce qu'on appelle la théorie de la calculabilité, justement un des pilliers de l'informatique théorique.

Tout comme son génial étudiant, Church était fasciné par les résultats de Gödel sur l'incomplétude de l'arithmétique9, et comme Turing, il était convaincu qu'il n’existe pas de solution universelle pour l’entscheidungsproblem. Cependant, cette limite sérieuse n'empêchait nullement le développement de l'algorithmique ou la formalisation du concept de calculabilité. C'est ainsi qu'il énonça la thèse, dite de Church ou de Church-Turing : elle stipule que si l'on peut formuler un problème de calcul quelconque en définissant une procédure algorithmique, alors on peut le résoudre grâce à une machine de Turing. Ou dit autrement : tout ce qui est calculable par un humain qui disposerait d'un algorithme et de ressources illimitées, est également calculable par une machine de Turing.

On le voit tout de suite, cette thèse ne constitue pas elle-même un énoncé mathématique. D'une part, elle propose un principe général de calculabilité qui n'est pas lui-même calculable, d'autre part, elle ne se prononce sur aucun type particulier de procédure algorithmique; on est donc en présence d'un énoncé métamathématique. C'est pourquoi on parle de thèse, et non de démonstration ou de théorème.

L'entrée en scène de Chaitin

Il faut maintenant aborder le travail de Gregory Chaitin (1947-). Ce mathématicien et informaticien américain d'origine argentine est considéré comme le Gödel de l'informatique, on va voir pourquoi.

Virtuose de l'informatique théorique, Chaitin a introduit deux notions révolutionnaires : le nombre Oméga et une première définition fonctionnelle du hasard. Commençons par la première notion.

Virtuose de l'informatique théorique, Chaitin a introduit deux notions révolutionnaires : le nombre Oméga et une première définition fonctionnelle du hasard.

On se souvient de la définition d'un nombre réel : c'est un nombre qui comporte une partie entière, et une mantisse composée d'un nombre indéterminé de décimales. L'ensemble des réels inclut donc les nombres rationnels, comme ¼ ou 4/3, mais aussi les nombres irrationnels, tels les constantes π (3,141 592 653...) et √2, la racine carrée de 2 (1,414 213 562...), dont l'écriture décimale n'est ni finie, ni périodique, comme l'est par exemple 4/3 (1,33333...). Une suite de décimales infinie est le cauchemar des mathématiciens, mais c'est aussi un formidable terrain de jeu. En son temps, Turing avait proposé une définition d'un nombre réel calculable : c'est un nombre dont la partie décimale doit être calculable avec des moyens finis. Autrement dit, il faut que, grâce à une méthode précise, une machine de Turing soit capable d'énumérer la suite de tous les chiffres du nombre en question. Cette suite peut être virtuellement infinie, pourvu qu'il existe des algorithmes permettant d'en donner une approximation de plus en plus fine, avec une précision connue. Ainsi, bien qu'appartenant aux réels irrationnels, √2 et π sont des nombres calculables10. Trouver les algorithmes les plus efficaces pour augmenter le nombre de décimales de π constitue d'ailleurs un sport très populaire. Ainsi, le 14 mars 2019, anniversaire du jour de π, Emma Haruka Iwao, une ingénieure de Google, a pu battre le record précédent et obtenir un résultat mirobolant : 31 415 926 535 897 décimales de ce nombre mythique, soit plus de 31 mille milliards11.

On peut aisément démontrer – ce que nous ne ferons pas ici – qu'il existe une infinité de fonctions non calculables, c.-à-d. des fonctions pour lesquelles il n'existe aucun algorithme12. Un exemple classique de ces fonctions est le célèbre problème de l'arrêt, lié à l’entscheidungsproblem de Hilbert. Comme le dit Chaitin, « aucun jeu d'axiomes ne nous permettra jamais de déduire qu'un programme s'arrêtera ou non13». À ce propos, il a introduit une constante Ω, le nombre Oméga. Il est assez complexe, mais en termes simples, on peut le définir comme la probabilité qu'un programme finisse par s'arrêter. Précisons que le programme en question doit être généré de manière aléatoire et que sa fin doit être prévue et codée dans le programme lui-même ; on dit alors qu'il est auto-délimité. Cette constante Ω, qui formalise le problème de l'arrêt, est un nombre réel transcendant, compris entre 0 et 1. Or, il présente une particularité très étonnante : tout en possédant une définition mathématique simple, il est incalculable. La suite de ses décimales ne peut être donnée par aucun algorithme. Comme les deux théorèmes d'incomplétude de Gödel en arithmétique, ce nombre paradoxal constitue un bel exemple de casse-tête, car il pose une limite apparemment infranchissable en théorie de la calculabilité, mais c'est aussi un cas admirable, car il concentre en quelques traits le caractère étrange de l'univers des réels. En effet, il s'agit d'un nombre parfaitement aléatoire. De fait, le travail de Chaitin permet de donner la première définition fonctionnelle du hasard : une suite de chiffres est parfaitement aléatoire s'il n'existe aucun programme qui permette de la produire en un nombre d'étapes inférieur à la suite elle-même. Comme, par définition, elle ne peut être réduite à un algorithme, une telle suite de chiffres est donc également incompressible. En somme, tout en étant parfaitement défini, Ω est à la fois incalculable, parfaitement aléatoire et incompressible. « L'incalculabilité, précise Chaitin, est une cause profonde de l'incomplétude14. »

Les promesses de l'ordinateur quantique

On l'a vu dans la première partie de cette chronique, les promesses de la suprématie quantique font rêver. Projetons-nous un instant dans le futur et supposons que, sortie des laboratoires, cette technologie innovante est désormais adoptée. Considérant ce qu'on a obtenu avec seulement quelques qubits, le potentiel de l'hyperordinateur quantique semble, à toutes fins utiles, illimité. Mais est-ce vraiment le cas? Pourrait-il résoudre des problèmes qui dépassent les possibilités de l’ordinateur classique? Par exemple, le nombre Oméga, une limite infranchissable pour un appareil classique, pourrait-il alors perdre son statut? Pour analyser ces questions, faut-il imaginer un modèle théorique différent d'une machine de Turing? Si oui, lequel, et sinon, pourquoi? Autant de questions difficiles, dont les réponses ne sont rien moins qu'évidentes.

Avant de les examiner et d'amorcer la dernière partie de ce texte, précisons que l'on aborde ici un terrain spéculatif, au sens où plusieurs des avenues explorées par les spécialistes demeurent, pour le moment, hypothétiques. Cela ne signifie pas que l'on peut dire tout et son contraire, mais que, même appuyées par de solides arguments, certaines assertions ne seront pas vérifiables et encore moins vérifiées; elles relèvent de la conjecture raisonnable. Pour cette raison, on verra que, parfois, les avis divergent.

Un hypercalcul pour de superordinateurs?

L'ordinateur quantique permet d’effectuer certains calculs à une vitesse inimaginable pour un ordinateur fonctionnant de manière standard, soit. Comme l'a rappelé la première partie de cette chronique, ce décuplement est rendu possible par l'étrangeté de l’univers quantique, entre autres les superpositions d’états, l’intrication et la cohérence. Toute la question est alors de savoir quelles seront les limites de ces appareils non classiques.

Dès les années 1970, en fait dès le moment où on a proposé le concept d'ordinateur quantique, on a commencé à élaborer des modes de programmation adaptés. Le physicien américain Paul Benioff fut l'un des pionniers en la matière. En 1980, dans un article qui a fait date, il publiait le modèle quantique d'une machine de Turing15. Bien que plusieurs chercheurs aient été sceptiques au début, le champ s'est rapidement développé, entre autres grâce à l'immense prestige de Feynman. Aujourd'hui, c'est un domaine de recherche florissant, qui pose nombre de questions palpitantes, mais actuellement insolubles.

Parallèlement à ces travaux, d'autres chercheurs se penchaient sur la possibilité de développer des formes d'hypercalcul. On entend par hypercalcul – certains chercheurs préfèrent parler de calculs super-Turing –, des modèles qui donneraient des résultats non Turing-calculables, c.-à-d. qui dépassent les possibilités d'une machine de Turing, et donc aussi de son incarnation, l'ordinateur standard. Ainsi, une machine destinée à résoudre le problème de l'arrêt, et donc à solutionner le nombre Oméga, devrait utiliser une forme d'hypercalcul. Deux questions se posent alors : 1) de tels hypercalculs sont-ils destinés à demeurer à jamais inaccessibles? 2) Sinon, l'ordinateur quantique constitue-t-il un pas vers une machine capable d'effectuer de tels calculs?

Il n'existe actuellement aucun consensus sur la réponse à ces deux questions. Pour beaucoup de chercheurs, le bond réalisé par l'ordinateur quantique, tout exceptionnel soit-il, demeure un bond quantitatif. Cela signifie que même en accélérant dans des proportions vertigineuses les calculs, il ne change pas fondamentalement la nature d'une machine de Turing. En pareil cas, la thèse de Church-Turing demeurerait valide et le problème de l'arrêt resterait insoluble ou, pour employer le langage de Gödel, indécidable. Ainsi, dans « Architecture des ordinateurs », un long texte très documenté et solidement argumenté, l'auteur, un physicien non identifié, conclut :

Qu’est-ce qui justifie donc l’engouement autour des ordinateurs quantiques? Leur véritable nouveauté, c’est l’espace des états manipulés qui est de type vectoriel et qui permet, via les possibilités offertes de définir des états superposés, d’imaginer de nouvelles formes d’algorithmes. Ces algorithmes quantiques permettent de calculer plus vite les solutions à certains problèmes, comme l’algorithme de Shor qui permet de factoriser un nombre entier en temps polynomial, menaçant ainsi l’un des fondements de la cryptographie moderne. On peut même imaginer à terme que les capacités offertes par les ordinateurs quantiques puissent bouleverser l’état actuel de la théorie de la complexité, mais en aucun cas un ordinateur quantique ne permettra de calculer des choses nouvelles. L’architecture basée sur le modèle des machines de Turing est donc bien le paradigme ultime pour calculer ce qui est calculable16!

Il s'agit certes d'une position très tranchée, mais qui recueille l'adhésion de plusieurs spécialistes. Un argument puissant milite d'ailleurs en sa faveur. En 1939, soit trois ans après la parution du remarquable article introduisant la machine universelle qui porte maintenant son nom, Turing publie un autre texte intitulé Systems of logic based on ordinals. Il y reprend les éléments de sa thèse de doctorat du même titre, soutenue à Princeton sous la direction de Church en 1938. Ces développements poursuivent son travail sur les propositions indécidables de Gödel et introduisent une sorte d'hypercalcul, basé sur le concept d'oracle. Un oracle est un outil virtuel, une abstraction mathématique permettant de calculer des fonctions inaccessibles à une machine de Turing. On utilise cet artifice théorique, qui est une simple boîte noire, pour résoudre ou contourner des problèmes qui ne peuvent être traités de manière algorithmique, ce qui est parfois utile pour faire progresser la théorie de la calculabilité.

Grâce à ce procédé, Turing put étudier des systèmes plus puissants que celui analysé par Gödel et outrepasser la thèse de Church-Turing. Or, il montra que, même dans ce cas, des propositions indécidables persisteraient. En effet, comme on l'a fait remarquer depuis, si une o-machine, une machine supérieure comportant un oracle, peut déterminer à quel moment doit s'arrêter une machine de Turing, résolvant ainsi le problème de l'indécidabilité, qu'est-ce qui va déterminer la décision de cette o-machine? Après tout, elle repose sur un oracle, non sur un algorithme. Autrement dit, la machine oraculaire devient alors à son tour assujettie au problème de l'arrêt. Faudra-t-il donc une o-machine d'un autre niveau, pourvue d'un oracle de puissance supérieure, pour justifier la décision de l'o-machine initiale? On voit qu'à ce rythme, on aboutit rapidement à une régression à l'infini, ou du moins à une hiérarchie de machines, renvoyant la proposition indécidable à des niveaux de plus en plus élevés, qui ne la rendent pas moins épineuse17. C'est la conclusion à laquelle arrive un chercheur comme Klaus Mainzer (1979-) : « In general, no oracle machine can solve its own halting problem18. »

Si Turing et Mainzer ont raison, on ne pourrait donc résoudre le problème de l'arrêt et le nombre Oméga garderait son mystère, ce qu'on peut interpréter de la manière suivante : même si l'ordinateur quantique pouvait un jour jouer en quelque sorte le rôle d'oracle et qu'il parvenait à résoudre des problèmes nouveaux à une vitesse stupéfiante, certaines limites demeureraient infranchissables. Cela signifierait que, comme dans le cas des relations d'incertitude d'Heisenberg en physique quantique, nous sommes en présence, non de bornes pragmatiques, mais de limitations de principe. C'est pourquoi, affirme Chaitin dans une formule saisissante, le nombre Oméga représente « le comble de l'inconnaissable, [...] la présence du chaos dans l'intimité des mathématiques19.» Et, selon toute vraisemblance, ce chaos y est installé à demeure.

Pour ne pas conclure

Évidemment, nous sommes là dans le domaine de la spéculation, et même les meilleurs arguments pourraient être un jour invalidés par les progrès de la recherche. Ainsi que le disait Hamlet, il y a plus de choses dans le ciel et sur la terre que n'en peut rêver la philosophie... ou l'informatique théorique. Peut-être, après tout, la suprématie quantique nous réserve-t-elle des surprises de taille. Mais selon toute vraisemblance, les limitations de principe identifiées par Gödel, Turing et Chaitin continueront de contrecarrer les efforts des chercheurs. C'est là une conclusion parfaitement raisonnable... pour l'instant.

- 1Pour un rapide aperçu des travaux de Turing et des origines lointaines d'une telle machine, voir notre chronique, « Puis Turing vint... » (adresse URL : https://www.acfas.ca/publications/decouvrir/2015/02/puis-turing-vint).

- 2Écrit en 1936, il fut publié l'année suivante dans les Proceedings of the London Mathematical Society. J'ai aussi donné un aperçu de l'entscheidungsproblem, le problème de la décision, dans « Puis Turing vint... » Il existe une controverse sur le but exact poursuivi par Turing dans ce texte, certains prétendant que l'idée d'une machine universelle, matérialisée entre autres par l'ordinateur, est en fait postérieure; laissons les spécialistes débattre de cette question.

- 3J'utilise volontairement le terme neutre d'automate, car ce texte fondateur a aussi soulevé un débat : pour Turing, le modèle computationnel mis en œuvre évoquait-il d'abord une machine ou un humain? Il utilise le terme computer. Or, comme chacun sait, c'est le terme anglais qui désigne l'ordinateur. Mais le comput est un mot ancien qui évoque le fait de calculer et, à l'époque, un humain engagé pour réaliser des calculs complexes était appelé un computor ou, parfois aussi, un computer. Souvent, d'ailleurs, c'était à des femmes qu'on confiait ces tâches fastidieuses (voir David Alan Grier, When Computers Were Human, Princeton University Press, 2007). Alors, quand il fait allusion à une procédure mécanique effectuée par un computer, Turing pense-t-il à un humain ou à une machine ? Les spécialistes divergent encore sur ce point et ce n'est pas ici le lieu de prendre position dans ce débat. Rappelons simplement que, de nos jours, le computer électronique effectue sur une base quotidienne la mécanisation de calculs ingrats autrefois confiés à de pauvres personnes...

- 4Le document canonique où il les décrit est intitulé First Draft of a Report on the EDVAC, EDVAC signifiant Electronic Discrete Variable Automatic Computer. L'EDVAC, conçu en 1945 et opérationnel en 1949, fut le premier ordinateur à fonctionner en mode binaire. Il remplaça l'ENIAC, l'Electronic Numerical Integrator and Computer, que l'on considère souvent comme le premier calculateur universel, mais qui utilisait encore le système de numération décimale traditionnel en Occident.

- 5Cette étape correspond aux divers états de la machine de Turing.

- 6Elle correspond au ruban de la machine de Turing. Précisons que les informations nécessaires ne pouvant être toutes transmises sous forme de programme, certaines d'entre elles, plus basiques, doivent être stockées dans une composante physique de l’ordinateur. La mémoire interne est ainsi constituée d'un certain nombre de cases (ou mots binaires) contenant indifféremment les instructions machine d'un programme de traitement, des données à traiter et des résultats à fournir.

- 7Les premiers ordinateurs ne comportaient ni clavier intégré ni imprimante. Ainsi, au début, on programmait l'appareil en branchant des câbles à des tableaux de connexion enfichables; plus tard, on coda le programme sur des cartes perforées, qu'exécutait ensuite l'ordinateur. C'est ensuite seulement qu'apparut le clavier.

- 8Voir à ce propos la partie I de cette chronique, à l'adresse URL : https:// www.acfas.ca/publications/decouvrir/2019/11/nombre-omega-ordinateur-quantique-partie-1-suprematie-quantique.

- 9J'ai exposé brièvement le lien entre les travaux de Gödel et ceux de Turing dans la chronique déjà citée, « Puis Turing vint... »

- 10Pour des nombres tels que π, qui a un statut différent, les mathématiciens ont créé une catégorie spéciale, les nombres transcendants.

- 11« Google explose le record de calcul de décimales de pi »; adresse URL : https://www.01net.com/actualites/google-explose-le-record-de-calcul-de-decimales-de-pi-1652494.html.

- 12On se souvient que dans sa théorie des nombres transfinis, Cantor, moyennant l'axiome du choix, avait fait de l'ensemble des nombres réels l'exemple-type de l'infini non dénombrable, par opposition aux infinis dénombrables, dont l'exemple-type est la suite des entiers naturels. Il symbolisa le second ensemble par aleph-zéro (ℵ0); quant au premier ensemble, dont la cardinalité est 2ℵ0, il le supposa égal à aleph-un (ℵ1), le premier ordinal transfini non-dénombrable - c'est ce qu'on appelle depuis l'hypothèse du continu.

- 13« Le monde est-il une équation insoluble? », La recherche, no thématique 31, Les maths et le réel. Comment décoder le monde, sept.-nov. 2019, p. 57.

- 14Hasard et complexité en mathématiques (traduction de Meta Math ! The Quest for Omega, 2005), Paris, Flammarion, 2009, p. 64. Pour ceux et celles qui voudraient approfondir ces questions, cet ouvrage, à la fois brillant et accessible, constitue une excellente initiation.

- 15« The computer as a physical system: A microscopic quantum mechanical Hamiltonian model of computers as represented by Turing machines », Journal of Statistical Physics, vol. 22, no 5, mai 1980, p. 563-591; adresse URL : https://www.researchgate.net/publication/226754042_The_computer_as_a_physical_system_A_microscopic_quantum_mechanical_Hamiltonian_model_of_computers_as_represented_by_Turing_machines.

- 16Publié en deux parties, « Architecture des ordinateurs » reprend les grandes lignes d'une formation donnée par le cabinet français Quantmetry, spécialisé en Intelligence Artificielle. Il est disponible sur le site de l'organisme; adresse URL : https://www.quantmetry.com/architecture-des-ordinateurs-2-2/.

- 17Le problème de la décision peut être envisagé selon différents degrés de difficulté. Cette question relève de ce qu'on appelle la théorie de la complexité, proche parente de la théorie de la calculabilité, et je n'en tiens pas compte ici.

- 18The Digital and the Real World. Computational Foundations of Mathematics, Science, Technology, and Philosophy, New Jersey et al., World Scientific Publishing Co., 2018, p. 50.

- 19« Le monde est-il une équation insoluble? », op. cit., p. 59.

- Jean-Claude Simard

Université du Québec à Montréal

Jean-Claude Simard a longtemps enseigné la philosophie au Collège de Rimouski, puis l’histoire des sciences et des techniques à l’Université du Québec à Rimouski, d'où il est présentement professeur retraité. Il croit que la culture scientifique a maintenant conquis ses lettres de noblesse et que, tant pour le grand public que pour le scientifique ou le philosophe, elle est devenue tout simplement incontournable dans le monde actuel.

Vous aimez cet article?

Soutenez l’importance de la recherche en devenant membre de l’Acfas.

Devenir membre