Vincent Larivière et Rodrigo Costas, Université de Montréal

Chronique Les mesures de la recherche

13 octobre 2016

La massification des évaluations…

Au cours des deux dernières décennies, les évaluations quantitatives de la recherche se sont massifiées. Elles sont facilitées par l’arrivée d’outils tels que Google Scholar et la création d’indicateurs, tels l’indice H, qui visent spécifiquement l’évaluation des individus plutôt que celles des institutions et des pays. Bien que dans certains pays – tels la Belgique1 et la Grande-Bretagne –, ces évaluations quantitatives soient utilisées en complément avec l’évaluation par les pairs, dans d’autres, comme l’Autriche, la Norvège, le Danemark, la Suède et la Finlande, ils représentent le principal mode d’octroi de la permanence, de la gestion de rémunération et du financement des travaux des chercheurs. Ces modes d’évaluations sont donc susceptibles de modifier les pratiques de publications des chercheurs.

… et ses effets pervers

Ces effets sur les pratiques de publications des chercheurs ne sont pas toujours positifs : par exemple, en réponse à une structure d’évaluation mettant l’emphase sur le nombre d’articles publiés (plutôt que sur leur impact), les chercheurs australiens ont effectivement augmenté leur productivité… mais principalement dans des revues à faible impact et à haut taux d’acceptation!2 Toutefois, hormis cette étude de cas – et quelques autres – nous savons bien peu de choses sur la relation, à l’échelle des chercheurs, entre la productivité et l’impact scientifique. Basée sur un article récemment publié dans la revue PLOS One3, cette chronique vise à fournir quelques données sur cette relation. Plus spécifiquement, nous cherchons à répondre à la question suivante : comment la proportion d’articles hautement cités évolue-t-elle en fonction de la productivité des chercheurs? Est-ce que les plus productifs publient une proportion plus élevée d’articles hautement cités ou est-ce plutôt les moins productifs, qui mettraient davantage d’emphase sur la « qualité »?

Un échantillon mondial

Désambiguïsé à l’aide d’un algorithme qui prend en compte les pratiques de publications des chercheurs4, l’échantillon analysé ici comprend 28,078,476 chercheurs ayant publié au moins un article dans le Web of Science au cours de la période 1980-2013. De ce lot, deux cohortes sont spécifiquement étudiées : des chercheurs établis, ayant écrit leur premier article au cours de la période 1981-1985, et de nouveaux chercheurs, qui ont publié leur premier article entre 2009 et 2013. Afin d’étudier les différences entre les disciplines, ces chercheurs ont été groupés en quatre familles de disciplines en fonction des lieux où ils publient : la médecine, les sciences naturelles, les sciences sociales, et les arts et humanités. Le comptage du nombre d’articles utilisés est effectué de façon unitaire : chaque auteur se voit comptabilisé un article entier (et non pas une fraction), et le calcul du top 1% des articles les plus cités est normalisé selon les disciplines, et il exclut les autocitations.

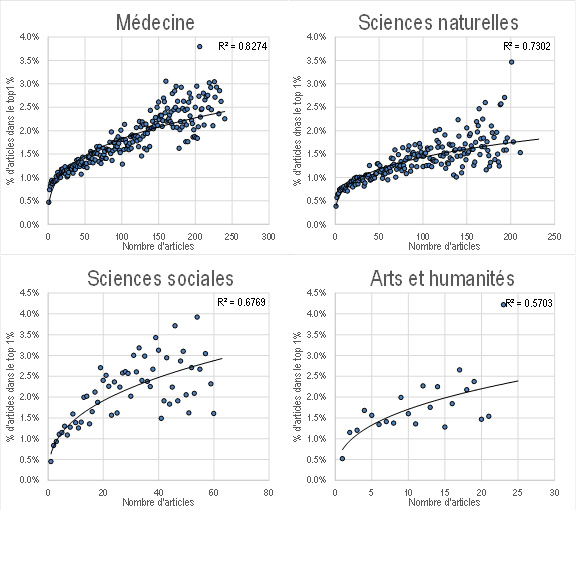

Une tendance claire pour les chercheurs établis

La Figure 1 présente, pour la cohorte des chercheurs ayant publié leur premier article entre 1981 et 1985, la proportion moyenne d’articles parmi le top 1% des articles les plus cités en fonction du nombre d’articles publiés. On remarque clairement une relation positive, et ce, pour chaque domaine. En effet, les chercheurs ayant publié un faible nombre d’articles sont, en moyenne, moins susceptibles de contribuer à un article hautement cité, et la proportion moyenne d’articles hautement cités augmente en fonction du nombre d’articles auxquels les chercheurs ont contribué. Toutefois, l’intensité de la relation varie selon le domaine : elle est plus forte en médecine (R2=0.83) et sciences naturelles (R2=0.73) qu’en sciences sociales (R2=0.68) et arts et humanités (R2=0.57).

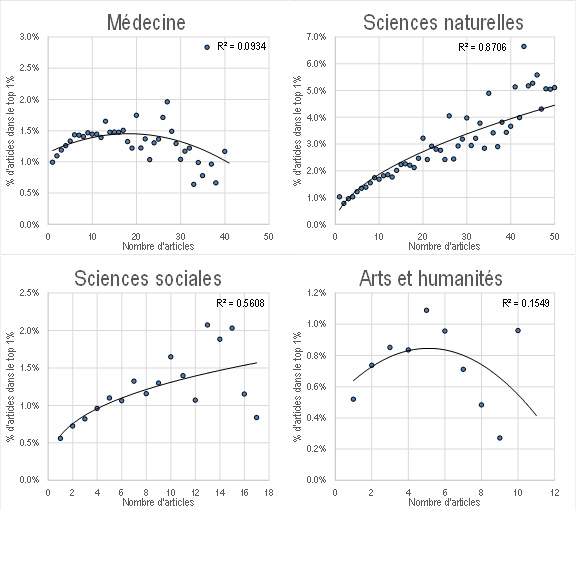

Des résultats mitigés pour les jeunes chercheurs

Pour les jeunes chercheurs (Figure 2), la tendance est moins claire. Alors qu’en sciences naturelles (et jusqu’à un certain point, en sciences sociales), la tendance est similaire à celles obtenues par les chercheurs établis, on observe des rendements décroissants en médecine, et arts et humanités, à partir d’un certain nombre de publications. En effet, dans ces deux grandes familles disciplinaires, ce ne sont pas les chercheurs les plus productifs qui, en moyenne, publient une proportion plus importante d’articles hautement cités, mais plutôt les chercheurs situés au milieu de la distribution. Une caractéristique importante de ce groupe de jeunes chercheurs est qu’elle a été socialisée à la recherche au cours des dernières années, alors que la culture de l’évaluation était plus présente, ce qui peut les inciter à tenter de publier le plus possible et, peut-être parfois, aux dépens de la qualité de leurs travaux. Cette tendance peut également être due à leur statut souvent précaire (postes non permanents, stages postdoctoraux à répétition), ce qui pourrait les amener à être moins sélectifs dans ce qu’ils choisissent de publier.

Une relation plus complexe qu’anticipée

Nos résultats montrent que, pour les chercheurs établis, et pour les jeunes chercheurs de certaines disciplines, quantité et qualité vont de pair. Plus les chercheurs publient, plus ils sont susceptibles, en moyenne, de voir leurs articles figurer parmi les plus importants de leur discipline. Ces résultats sont cohérents avec la théorie mertonienne des avantages cumulatifs : plus un chercheur publie, plus il devient connu de ses pairs qui sont davantage attirés vers ses travaux favorisant ainsi un nombre plus élevé de citations. Cela pourrait également expliquer l’absence d’une telle relation pour les jeunes chercheurs, qui n’ont pas encore eu le temps de se faire un « nom » dans leur discipline.

Il semble donc que la relation entre production et impact soit plus complexe qu’anticipée, et que l’emphase sur la quantité ne soit pas clairement associée à un déclin de la qualité. Bien que cela puisse être considéré comme une bonne nouvelle, le fait que cette relation soit moins claire pour les jeunes cohortes incite à la vigilance, et nous permet de rappeler que l’évaluation par les pairs demeure la meilleure façon d’évaluer la performance des chercheurs individuels.

- 1Debackere K, Glänzel W. (2004). Using a bibliometric approach to support research policy making: The case of the Flemish BOF-key. Scientometrics, 59(2): 253-276.

- 2Butler L. (2003). Modifying publication practices in response to funding formulas. Research Evaluation, 12(1): 39-46.

- 3Larivière V, Costas R, (2016). How many is too many? On the relationship between research productivity and impact. PLOS ONE, 11(9): e0162709.

- 4Caron E, van Eck NJ. (2014) Large scale author name disambiguation using rule-based scoring and clustering. In 19th International Conference on Science and Technology Indicators. Context counts: Pathways to master big data and little data. CWTS-Leiden University Leiden, 79-86.

- Vincent Larivière

Université de Montréal

Vincent Larivière est titulaire de la Chaire de recherche du Canada sur les transformations de la communication savante, professeur adjoint à l’École de bibliothéconomie et des sciences de l’information de l’Université de Montréal, membre régulier du CIRST et directeur scientifique adjoint de l’Observatoire des sciences et des technologies. Ses recherches s’intéressent aux caractéristiques des systèmes de la recherche québécois, canadien et mondial, ainsi qu’à la transformation, dans le monde numérique, des modes de production et de diffusion des connaissances scientifiques et technologiques. Il est titulaire d’un baccalauréat en Science, technologie et société (UQAM), d’une maîtrise en histoire (UQAM) et d’un Ph.D. en sciences de l’information (Université McGill).

- Rodrigo Costas

Université de Leiden

Rodrigo Costas est chercheur du Centre for Science and Technology Studies de l’Université de Leiden aux Pays-Bas depuis 2009, où il s’intéresse au développement d’indicateurs bibliométriques, aux pratiques de remerciements des auteurs, ainsi qu’au rôle des médias sociaux dans la diffusion des connaissances. Il détient un doctorat en sciences de l’information du CSIC (Espagne).

Vous aimez cet article?

Soutenez l’importance de la recherche en devenant membre de l’Acfas.

Devenir membre

Commentaires

Articles suggérés

Infolettre